除了像响尾蛇、蝙蝠等少数动物依靠红外、超声等进行远程感知之外,绝大多数动物都是依靠视觉实现远程感知的,从而为捕猎食物、逃避天敌提供支持。对于人类和其他高等动物而言,视觉是实现学习能力的重要基础,没有视觉的支持,动物无法从行为中获得行为结果的反馈并进而指导行为的调整。类似地,对人工智能系统而言,计算机视觉同样是最为基础和重要的部分。计算机视觉早期的目标定位在利用一幅或多幅图像实现对三维世界的重建和物体(通常也称为“对象”,本文后面统一使用“对象”的说法)识别等方面,后者也常常被称为图像识别。

对计算机视觉的探索始于20世纪60年代初麻省理工学院(MIT)的一些研究。一个广为流传的说法是1966年夏天,马文·明斯基(Marvin Minsky)的研究组安排本科生将摄像机连接到计算机上,试图让计算机理解所看到的场景[1]。同样在MIT,拉里·罗伯茨(Larry Roberts)于1963年提交了题为“Machine Perception of Three-Dimensional Solids”的博士论文,研究了对于三维积木世界的理解问题。罗伯茨后来转向网络领域,与温顿·瑟夫(Vint Cerf)等一起被誉为互联网之父[2]。尽管在80年代初,以戴维·马尔(David Marr)为代表的学者建立了相对完善的计算视觉理论体系[3],但由于发展中遇到的困难,这一领域在经历了最初进展之后也和人工智能的其他领域一样,受到人工智能寒冬带来的影响。

图像识别与理解

经历了数十年的研究,图像识别取得了长足的进展。从90年代开始,图像识别的能力有了飞速的提升,这可以从以下两个方面看出:

1. 在特定类别的识别上,计算机视觉系统的识别能力已经超过了大多数普通人,一个典型的例子是人脸识别技术的进展。刷脸技术的广泛应用是这一技术逐渐走向成熟的印证。人脸识别技术在几个典型数据集合上的性能先后逼近到极限附近也说明了这一点,图1是一些方法在LFW数据集1上的性能表现。尽管在更为复杂的情形下(如在PaSC数据集2上)这类问题还有很长的路要走(图2),但至少说明在限定环境下,人脸、车辆等特定类别的识别问题已经取得了具有实用价值的性能。

图1 在LFW上人脸识别性能的对比[4]

图2 PaSC上识别能力的对比[5]

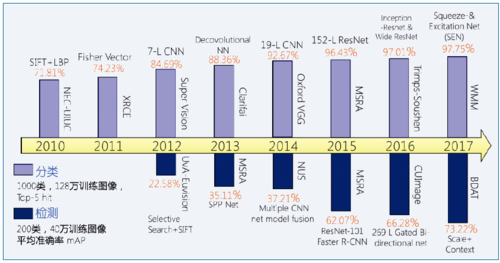

2. 从2000年前后开始,多类别识别问题再次受到关注。包括SVM、AdaBoost、BoW以及SIFT等方法的进步促进了这一领域的发展。在衡量这一领域进步的道路上,ImageNet扮演了一个非常重要的角色。在ImageNet上识别性能的对比见证了识别技术的进步(图3)。与此同时,和所有数据集合的作用类似,当性能逼近极限的时候,这一数据集合也完成了其历史使命,2017年也成为利用这一数据集进行公开测试竞赛的最后一年。

图3 ImageNet上检测/识别性能的变化

在上述过程中,深度学习起到了重要的作用。从Roberts算子开始,由于计算和存储能力的限制以及数据的受限,我们一直在使用由手工精心设计的各种特征进行识别。尽管这类设计受到了心理学研究的启发和数学方法的指导,并在无须从环境中学习的条件下发挥了重要的作用,但却难以完成复杂情形下的任务。深度学习提供了从数据中学习有效特征的方法,加之大规模数据的获取越来越便捷,以及计算能力的提升,使得识别能力达到了接近应用需求的水平。近年来以识别技术为核心的创业潮也从一个侧面印证了这一进步。

参考从低级到高级动物的视觉系统,不难发现,在动物视觉系统中,识别仅仅是其中的一个中等水平的能力,更为简单的视觉能力是类似青蛙的检测运动,而对于高等动物而言,更为重要的能力是对识别对象的理解和推理等。关于理解,不难从一些动物的行为中获得启发——乌鸦向瓶中投石喝水以及鸟类建造鸟窝等都是动物在识别基础上进一步具有理解能力的体现。

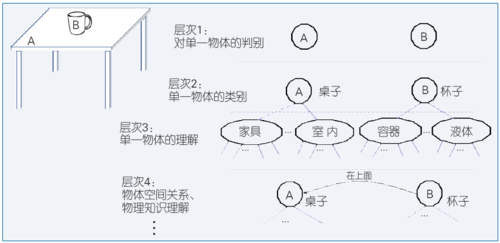

对计算机视觉而言,在识别问题取得进展之后,下一个重要的目标应该是实现对对象的理解,并进而实现对场景的理解,不仅知其然,更知其所以然。理解是一个复杂的层次化过程,一般意义上的检测、识别等都可以看作是理解中的一个层次,如图4所示。理解可以看作是从对象检测、识别、结构解释、功能,直至物理属性的逐层理解。这其中有些是通过图像获得的,有些是通过时间域的信息获得的,如对象的运动、行为等。至于功能的理解,可以来自与对象类别/属性相关的知识或者从环境中学习获得的知识。物理属性则可以提供关于各种运动、平衡的知识与对未来可能运动的预测,这些能力是动态环境中的视觉系统所迫切需要的。

图4 理解的层次

从对象空间到概念空间

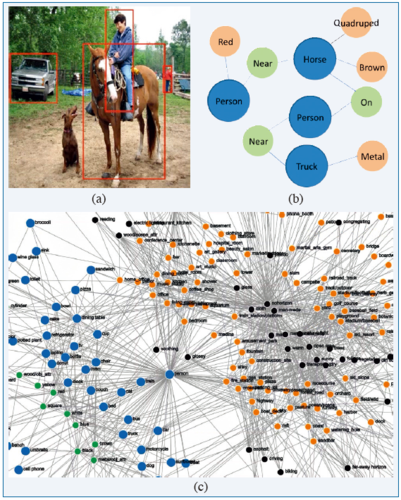

对场景的理解可以从空间的角度考虑,视觉信息理解的目的是从对象空间(场景物理空间)到概念空间的映射。其中必然经过从对象空间到图像空间的映射,这一过程一般是由成像设备完成的,而关键是后续的从图像空间到概念空间的映射。从图像空间得到相应的概念及其概念之间的关系,可以获得相应场景的概念关系,与此同时,借助关于概念的背景知识,可以获得对概念的进一步理解,如图5所示。

图5 关于概念的知识,图(c)可以将从图像空间(a)中获得图像场景关系,并对(b)进一步完善

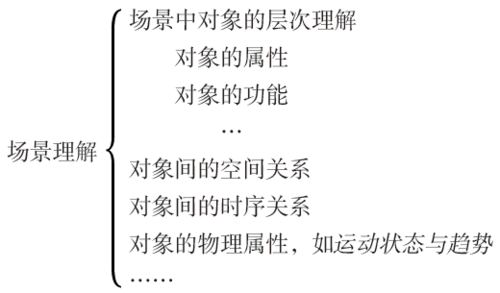

一般意义上的场景理解包括以下含义:

场景理解在统计方法大行其道的今天,识别往往是从图像空间直接得到关于类别的结果,而忽略了类别的相关含义和类别间的关系。大多数表征对象类别的特征向量既未反映出类别与其属性的关系,也未能实现不同类别间相同或类似属性的共享,因而类别与支撑类别的空间的分量或子空间之间缺乏语义上的关联。如果从类别和支撑类别的语义子空间角度考虑,对象可以看成是由属性张成的子空间中的点,因而可以构成从属性到类别的关联,或者通过考察属性与对象之间的相关关系,构成属性与类别之间的因果关系。属性可以看作是更加具有泛化能力,但却较少确定性的类别,也是分类的准则和聚类的基础。日常生活中各种层次的分类,例如动物、植物的分类等,大多与相应的属性有关。

相比直接的对象识别,建立以层次化表达为基础的识别,可以为识别的结果提供因果或者至少是关联关系的支撑,同时可以实现和人类概念一致的感知,如我们对鸟类的识别大多数停留在称呼鸟的层面,而对于企鹅、鸵鸟等有特点的鸟类则会使用更为精细的分类名称,进而实现对对象的层次关系的理解。

场景理解与语言表达

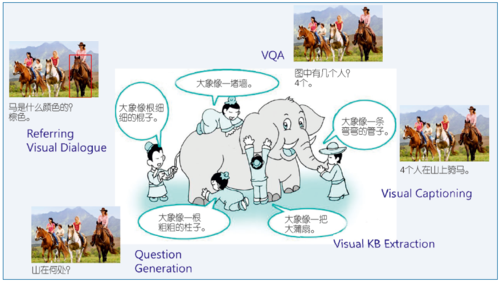

不同于以往单纯的识别任务,由于理解的多样性和不确定性,度量就成为重要的挑战之一。因而检验对场景理解的程度以及进一步对理解结果的运用都将不可避免地和语言表达相联系。这种度量一般通过语言交互来体现,近年来和语言相关的图像和视频分析工作逐渐受到重视,如Visual Caption、VQA、Question Generation等。这些工作虽然开启了这方面的研究,但往往试图直接实现相应的能力,缺乏对场景的实质性理解,多数是直接面向问题的end-to-end的方法,泛化能力弱。与此同时,从场景理解的角度出发,这些工作都只反映了理解的某个侧面。这种缺乏深入理解的语言交互尽管可以在一定意义上实现貌似理解的交互,却不能进一步处理更加复杂的工作。这种情形就像盲人摸象(图6)。对场景的较为完善的理解依赖于两个方面——对场景理解的内部描述以及和语言的连接与交互。这其中语言交互是表象,而理解场景才是实质。

图6 图像与语言相关的工作仅仅反映了图像理解的一个侧面

正因为如此,为了实现真正的场景理解就必须进行场景分析,场景分析结果是后续交互的基础支撑。利用层次化表达从图像/视频的分析中形成的对场景理解的初步场景图,以及从通用知识图谱中继承的知识最终形成以实体概念为节点,包含各种实体间关系的完善的场景图。后续的语言交互是在这一场景理解结果上的推理和演化。

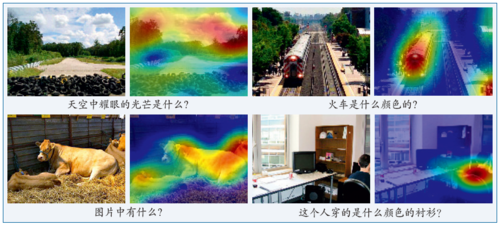

以图表达的理解结果为例,问答其实就是对缺失(子)图信息的补齐,或者是基于图信息的推理。为了实现语言和图像的交互,重要的是理解语言中表达的对象和关系在图像中的对应表象,也就是首先要实现重要概念或关系在概念空间和图像空间的对齐。图7给出了一些对齐的例子。从应用的角度来看,对齐的结果和语言推理的结合可以实现进一步的应用。

图7 语言概念与图像的对齐[6]

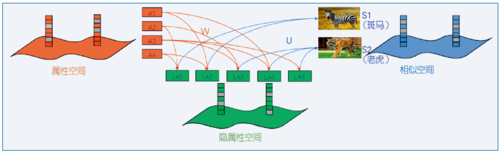

与此同时,对视觉知识的理解的另一个考察维度可以从推理和泛化能力考虑,一个典型的例子是对从未见过的类别,利用已有知识和属性因素推断其性质。这为我们提供了被称为零样本的学习能力,其实这里的零样本是指类别意义下的零样本,这种推断是利用了比类别更为精细的子类别或属性意义上的结果,借助对属性的聚合和推断能力,进而实现零样本的学习。

考虑到属性是某种聚类或分类的依据,由此形成了分类的基础和支撑,对于自动理解也需要具备这样的自动属性学习的能力,我们提出了一种自动的隐属性学习方法,通过两个变换W和U,将隐属性分别和(命名)属性以及类别建立起联系(图8)。基于自动学习获得的隐属性,可以实现对未知类型的识别和预测。学习得到的隐属性或者是某几种属性的聚合,或者是更为精细的属性分类,其结果取决于参与学习的类别的数量,这在一定程度上模仿了人类对事物区分的过程。

图8 属性、隐属性与类别的空间关系[7]

场景理解中知识的作用与视觉知识的学习

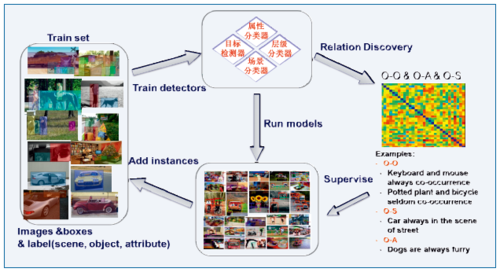

精细化、层次化的识别以及零样本识别等虽然进一步提升了对场景中对象的理解能力,但并未超越图像本身。要想获得更加深入的理解,不仅仅取决于从图像直接识别的结果,还取决于图像中对象以及对象间关系的背景知识。这些背景知识的获取和表达是非常重要的。通过背景的知识和属性的继承,可以获得对场景中对象的进一步理解。这些视觉知识的获取以及利用逐渐得到重视,如Visipedia[8]。我们从2014年起在国家自然科学基金委的支持下开展了视觉概念库的研究,试图自动发现视觉概念之间的关联关系,并通过不断累积的图像知识完善这一概念库(图9),从而为后续更加深入的图像/视频理解提供支撑。这里的关系包括对象与对象(O-O)、对象与属性(O-A)以及对象与场景(O-S)之间的关系。借助这一概念库可以实现超越图像表象本身的理解。

图9 视觉概念的学习与关系发现

展望

深度学习和大规模图像/视频数据使得自动学习特征成为可能,进而大大提升了自动识别的性能。但这种识别往往是孤立的,因而得到的结果也是知其然,而不知其所以然,缺乏对象与属性、对象与对象、对象与场景之间的关联,难以达到真正的理解。要实现更加全面理解的目的需要在以下几方面深入研究:

1. 具有触类旁通能力的零样本学习与识别;

2. 层次化的识别及与之相关的属性自动发现;

3. 从属性、对象到场景的跨层次关联关系发现与相应视觉知识的表示和推理;

4. 视觉时空特征与语言表达之间的对齐,进而和计算语言学相结合,实现“化一图为千言”的目标。

未来十年乃至更长的时间,场景理解将是这一领域的核心挑战,完善的理解将使得智能的水平得到质的提升。 ■

(本文根据CNCC 2017特邀报告整理而成)

脚注:

1 LFW数据集,人脸识别领域最重要的数据集合,是为了研究非限制环境下的人脸识别问题而建立。这个集合包含超过13000张人脸图像(全部来自互联网,而不是实验室环境)。每个人脸被标注了一个人名。 其中,大约1680个人包含两个以上的人脸。

2 Point and Shoot Face Recognition Challenge,详见参考文献[5]。

参考文献:

[1] Papert S. The Summer Vision Project.Vision Memo.No.100, MIT AI Lab, 1966.

[2] Draper Prize Honors Four 'Fathers of the Internet'[N]. Wall Street Journal, 2001-02-12.

[3] Marr D. Vision: A Computational Investigation into the Human Representation and Processing of Visual Information[J]. Quarterly Review of Biology, 1982, 8.

[4] http://vis-www.cs.umass.edu/lfw/results.html#guillaumin.

[5] Beveridge J R, Zhang H, Kan M, et al. Report on the FG 2015 Video Person Recognition Evaluation[C]// IEEE International Conference and Workshops on Automatic Face and Gesture Recognition. IEEE, 2015:1-8.

[6] Gao D, Wang R,Shan S, et al. Visual Textbook Network: Watch Carefully before Answering Visual Questions[C]//BMVC 2017.

[7] Jiang H, Wang R, Shan S, et al. Learning Discriminative Latent Attributes for Zero-Shot Classification[C]//ICCV 2017.

[8] Belongie S, Perona P. Visipedia circa 2015[J]. Pattern Recognition Letters, 2016, 72:15-24.

![图1 在LFW上人脸识别性能的对比[4] 图1 在LFW上人脸识别性能的对比[4]](..\..\upload\resources\image\2017\12\11\48907_500x500.png)

![图2 PaSC上识别能力的对比[5] 图2 PaSC上识别能力的对比[5]](..\..\upload\resources\image\2017\12\11\48908_500x500.png)

所有评论仅代表网友意见