引言

学术影响力评价一直是一个备受关注的话题,从论文的价值衡量到期刊的影响力刻画,从科研人员的业绩考核与晋升到诺贝尔奖的评选,从双一流高校的排名到国家创新能力的评估等,都涉及对研究成果的学术影响力如何进行科学的评价。作为科学研究的重要方向之一,学术影响力评价不仅是一个重要的科学问题,还对科研资源的分配以及国家科技政策的制定等方面具有重要现实意义。

学术影响力是指科研主体通过发表学术论文或论著等方式提出新的专业理论、实践方法与技术,或者对原有成果进行发展、修正、革新和完善,从而对相关领域的理论和实践产生影响[1]。传统的学术影响力评估方法主要是同行评审[2, 3],而目前被广泛应用的是引证分析法。引证分析法是利用各种数学及统计学方法以及比较、归纳、抽象、概括等逻辑方法,对期刊、论文、著者等各种分析对象的引用与被引用情况进行分析,以便揭示其数量特征和内在规律的一种文献计量分析方法[4]。近年来,也有一系列基于引文网络的新评价指标被提出并获得较好的效果。

同行评审

最早的关于同行评审的文献记载出现于公元9世纪,用于医疗诊断记录[5],随后阿拉伯人在此基础上发明了一种名为“Hisbah”的质量控制体系,并将其广泛应用于集市交易中[6]。1731年,爱丁堡皇家学会采用了一种新的审查方式,将待发表论文交给一组领域专家进行评审,编辑参考这些审稿意见,决定拒稿、修稿或接收。这一评审方式被认为是同行评审的真正开始[2]。为了提高可信度、公正度和评审质量,在原有基础上又进一步发展出了单盲同行评审[7]、双盲同行评审[8]和开放同行评审[9, 10],并广泛地应用于各个学科领域。

单盲同行评审

单盲同行评审是目前同行评审的主要方式,在审稿过程中只有审稿人是匿名的。有些人认为它提高了评审质量[11],在识别自我剽窃和利益冲突等方面优于双盲评审[12]。但是,也有人对此持反对意见[13, 14],认为它存在很多缺点,比如匿名的评审者很可能不负责任地给出过于严厉或者有失公正的审稿意见,或者对于熟识的作者给出“友好”的意见[15]。

双盲同行评审

双盲同行评审是指投稿人和审稿人均是匿名的,他们彼此都不知道对方的身份,只有编辑知道。这样做可以使审稿人不受投稿人身份的影响给出相对公正的评审意见[16]。同时,双盲评审能够避免更具一般性的偏见,如投稿人的性别、种族、国家、机构等[16~18]。交叉学科的研究者和年轻学者更偏爱这种方式[19]。尽管如此,在稿件中作者的信息可能处处都有些“暗示”,想要完全剔除这些信息是非常困难的。

开放同行评审

开放同行评审是指投稿人和审稿人的身份彼此公开,在评审的过程中他们可以直接交流。这一方式可使投稿人参与其中,让审稿过程更加公正,也可增强稿件评审过程的互动性,提高审稿人的责任感[13]。很多期刊已经采用这一方式,例如Nature Communications。该刊从2016年1月起试行审稿人的公开同行评审意见制度,但这一制度并不是强制性的,作者将被询问是否同意将同行评审的文件及文章的接收版本一起发表。有人认为开放同行评审最终将成为主流[20]。但是,这一方式会带来更大的工作量,也更耗时。

无论哪种方式,人们最关心的问题都是如何消除偏见。然而,审稿人的主观性不可能完全消除。编辑综合多个审稿人的意见最终决定是否发表,这在一定程度上弱化了个人层面的主观影响[15]。如何使同行评审更加公平合理是我们需要认真思考的问题。

引证分析法

与同行评审不同,引证分析法是一种定量化的方法。最早将引证分析法用于期刊学术影响力评价的人是美国著名情报学家和科学计量学家尤金·加菲尔德(Eugene Garfield)[21]。加菲尔德于1964年创立了SCI(Science Citation Index),使得人们可以将期刊网络作为一个整体来研究,同时它也打破了原来的主题索引和分类索引的限制[22]。1972年,加菲尔德正式将引文分析法用于科技期刊的质量评价,并提出期刊影响因子指标[21]。除此之外,由美国科学情报研究所(ISI)编辑出版的《期刊引证报告》(Journal Citation Reports)中还列出了其他评价指标,例如论文量、总被引次数、即年指标、被引半衰期等。2005年,赫希(Hirsch)提出了一种评价学者学术影响力的指标——H-指数[23]。该指标同时考虑了学者发表的论文数量和论文引用次数。由于其简单易算且含义明确,在科学计量领域引发了巨大的关注和讨论。

引证分析法并不度量专著或论文本身的质量,而是在能够测度的科学领域内,度量专著或论文等学术载体所包含的知识在不同学术主体(学科或学者)之间的转移量。学术成果只有在交流中才能体现出价值和影响力,否则就会像地下的金矿,虽然贵重,却不属于我们能够拥有和支配的财富。知识的转移通过引用关系显现出来,而引用的数量表征着转移量的大小。引证分析法和同行评审不能相互取代,只有互为补充才能更加全面和准确地评估学术主体的学术影响力[24]。

由于引用关系自身存在的一些缺点和现象,例如引而不用、用而不引、假引自引、引用的马太效应、不同学科间引用频次的差异等,以及SCI存在的期刊收录范围不全面,非第一作者的贡献被忽略等问题,使得引证分析法的准确性和合理性一直被质疑[25]。另外,引文分析中存在一个默认成立的前提,无论是被诺贝尔奖获得者引用了方法,还是被名不见经传的学者引用了结论,所有引文对被引论文的影响力贡献都是相同的。这显然是不合理的。

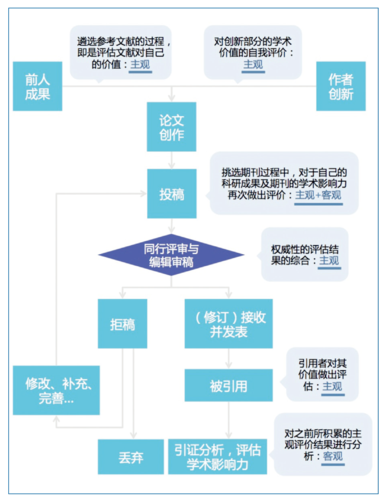

很多人认为引证分析法在很大程度上是一个客观的评价指标,因为专著或文章间的引用关系和引用数量显而易见,可以很方便地统计出来,而这些都是准确的、客观的可统计量。但实际上,客观性只是引证分析这一评价体系的美丽面纱,基于主观才是它面纱之下的真容。图1完整地展示了一篇论文(或专著)的“一生”,可以看出每一阶段的评价都受到人的主观影响,而投稿过程中的“客观”和最后的引证分析,都只不过是对之前所有的主观评价结果做了一次量化的、客观的分析或总结而已。

图1 一篇论文的“一生”

H-指数及其衍生指标

H-指数最初是用于评价学者的学术影响力。一个学者的H-指数等于h,表示在其所有论文中,至多有h篇论文每篇被引用至少h次。对H-指数的研究主要分三个方面:(1)理论分析。包括对H-指数进行数学理论上的分析与合理性考证[26],H-指数与传统文献计量指标的对比与实证研究[27],以及从信息价值理论及其他角度对H-指数进行分析[28]。(2)指标改进。为了解决H-指数的不足或优化其性能而衍生出一系列的H型指数,比如R-指数[29]、

m-指数[30]、K-指数[31]等,或者受H-指数启发提出的一系列类H-指数,比如g-指数[32]、w-指数[33]、

hα-指数[34]等。(3)应用拓展。H-指数不仅可以评价学者个体的学术影响力,还可以扩展到期刊、学术团体、机构、高校、甚至国家[35~37]。除此之外,

H-指数还可以用于热门课题的寻找[38],馆藏资源利用情况的分析[39],天文台的绩效评测[40],网络节点重要性的度量等[40]。

H-指数

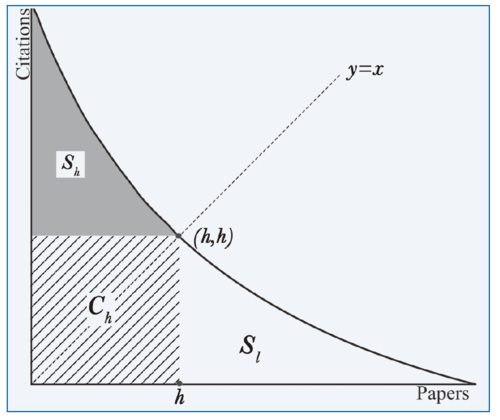

在图2中,我们将一位学者的所有论文按照引用次数降序排列,然后将它们的序号对应到X轴,每篇论文的引用次数对应到Y轴,绘制出这位学者论文的被引曲线。曲线与坐标轴围成的面积等于总引用数。这个面积中以(0,0)为一端点的最大正方形Ch(图2中斜线域)的边长就是这个学者的H-指数,也就是曲线与直线y = x的交点所对应的坐标值。H-指数也可以只使用论文的引用数量计算得到。H-指数虽然简洁,意义明确,且能很好地预测同行评审的结果,但也存在一些缺点:一是忽略了高被引论文的作用;二是不考察第h篇以后的所有论文的影响力,即图2中Sl区,即使它们的引用数都非常接近h;三是受到发表论文总数的限制——H-指数永远小于等于发表论文数。

图2 H-指数

基于这些问题,学者们在H-指数基础上提出一系列的改进指标,例如,强调高被引论文的价值的g-指数,hg-指数[42],AR-指数,w-指数[43],h(2)-指数[44]等;注重新论文引用贡献的hc-指数[45];考虑多作者分配问题的hI-指数[46]和hm-指数[47];考虑所有论文的被引价值的hT-指数[48]等。

基于引文网络的指标

上述引证分析指标都是将论文、作者、期刊等视为独立主体来进行分析评估的,只考虑与他们直接相关的引用。实际上,论文之间的引用关系是一张巨网,将所有文章通过引用关系连接起来,构成一个引文网络。由于一篇论文不可能引用在其后新发表的论文,因此这个网络是一个有向无环网络。早在1965年普赖斯(Price)就提出可以基于引文网络的分析来刻画论文影响力或重要性[49]。使用引文网络进行分析不仅考虑了一篇论文直接的引用信息,还考虑了这些施引论文的引用信息。1976年,宾斯奇(Pinski)和纳林(Narin)指出,可以将学术主体之间的论文引用次数看成引用网络中的连边权重来迭代计算论文影响力[50]。佩奇(Page)和布林(Brin)将这一思想率先应用于网页排序,并创造了在商业上大获成功的PageRank算法[51]。随后,PageRank算法被应用于引文网络中刻画论文或学者的影响力[52~55]。PageRank算法不仅考虑了引用的数量,还考虑了引用的质量。基于PageRank算法,学者们提出了一系列的改进方法,包括更加注重新论文的CiteRank[56],提升排序多样性的

DivRank[57],消除时间效应的重新标度的PageRank[58],处理缺失信息的PrestigeRank[59],考虑错误信息影响的NonlinearRank[60]和SPRank[61]。也有一些研究将PageRank方法扩展到学者-论文二部分图中,同时评价学者的学术声誉和论文的质量[62, 63]。

PageRank的思想也被用来衡量期刊的影响力。博伦(Bollen)等人[64]在期刊引用网络上用加权的PageRank方法来评价期刊,并将评价结果与影响因子比较,认为影响因子更多反映的是期刊的流行程度,而加权的PageRank方法所得的评价结果更能反映期刊的重要性。随后,韦斯特(West)和伯格斯特龙(Bergstrom)等人基于相似的思想提出了特征因子1指标[65]。与影响因子、H-指数等指标不同,特征因子除了考察引用数量外,还考察了施引者的影响力。一个期刊被高影响力学者引用越多,其影响力越大。2009年,汤森路透宣布推出《期刊引证报告》增强版,新增特征因子作为其正式的文献计量标准之一,并新增了特征因子分值和论文影响分值两个特征因子的衍生指标。有人对特征因子与原有的指标进行了分析比较,发现特征因子与原有各指标均有很强的相关性[66]。特征因子的计算过程根据引用者的不同对每条引用赋予不同的价值,且排除了期刊自引;论文影响分值作为特征因子分值的补充,使得载文量不同的期刊之间也能公平地比较[65,67]。但特征因子也美中不足,比如它对于低影响力的期刊群的区分能力较弱,而且计算过程中的数据封闭性较强,计算结果的准确性难以检验[68~71]。

展望

H-指数自2005年被提出以来,学者们对它的“热情”丝毫未减。虽然已有大量论文发表关于学术影响力的评价问题,但每一种方法都是从有限的角度进行评价,因此到目前为止还没有一个所谓的完美指标。

真实与公正是学术评价的最基本原则,任何指标的提出和完善都需以此为基石。综合已有的评价方法,我们总结出五点问题,希望在今后研究中可以得到完美解决。

引用质量的问题。无论是直接使用引用数还是构建引文网络,上述评价方法要想获得好的效果就必须保证引用数据是真实可靠且有价值的。因此要对引用的质量进行区分[60]。此外,还存在引用缺失的情况,即用而不引[59]。

先发优势的问题。优先连接机制是引文网络增长的一个重要驱动力[72]。实证研究显示论文引用受到“富者越富”机制的影响,即新发表的论文更倾向于引用已经被广泛引用的重要文献。越早发表的论文越有可能吸引更多的引用,因此将不同时间发表的论文直接进行比较对于新论文是不公平的。为了解决这个问题,在指标设计的时候就需要考虑时间因素。一些初步的尝试包括将一篇论文的引用数除以和它同时间发表的论文平均引用数[73],或者应用Z-分数的方式计算引用数(或者用其他指标得到的分值)的显著性[74]。

跨学科领域的比较问题。基于引用的评价方法都存在跨领域的比较问题,比如物理论文的引用一般大于数学论文。因此,评价指标的设计需要考虑不同学科领域的特点。例如,将评分值用同一领域论文的平均分数重新标度[58,73]。

指标缺乏预测能力的问题。静态的刻画指标缺乏对影响力增长的预测能力。有研究表明,论文的适应性[75]和时间衰减效应也是影响论文引用的重要因素[76]。基于以上因素就可以构建引用增长的预测模型。而论文的适应性本身就可以作为衡量论文影响力的指标。

合作论文学术贡献的分配问题。从研究人员的业绩考核到诺贝尔奖的评选都涉及到如何对合作论文进行合理的学术贡献分配。在以往的分配方法中都是注重第一作者和通讯作者的贡献,其他作者的贡献按作者排序递减。这个方法仅从单篇论文出发,虽然简单易算,但并不一定合理。一种新的思路是在考察作者对一篇学术论文的贡献时还需要考虑这些作者发表的其他相关的论文,这种方法对诺贝尔奖具有更高的预测能力[77]。

学者在社交媒体的学术影响力评估也是一个不能忽视的问题。以往研究中已有大量方法基于学者的合作关系(学术社交关系)刻画其学术影响力[78]。随着社会化媒体的发展,学者不仅可以在学术期刊发表论文,还可以在第一时间通过社交媒体发表最新的学术成果和观点。今年9月,浙江大学出台的一条学术新规上了头条:按照规定,浙江大学师生在指定的媒体发表原创文章,阅读量超过10万,可等同于发表学术论文。暂且不论其是否合理,这一现象的背后反映的正是基于社交媒体的学术影响力计算以及新型学术评价指标的适用性和科学性等问题。未来,我们在继续完善现有学术成果评价体系的同时,还需同时思考和探索将在社交媒体上发表的研究成果纳入学术考评体系的方式。这些问题无疑将为学术影响力的评价提出新的挑战。 ■

致谢:

感谢国家自然科学基金11622538和61673150及浙江省自然科学基金LR16A050001的支持。

注释:

1参见http://www.eigenfactor.org/。

参考文献:

[1] Houten BAV, Phelps J, Barnes M, Suk WA. Evaluating scientific impact[J]. Environmental Health Perspectives. 2000,108(108):A392-3.

[2] Spier R. The history of the peer-review process[J]. Trends in Biotechnology . 2002,20(8):357-8. doi: 10.1016/s0167-7799(02)01985-6.

[3] Cole S, Rubin L, Cole JR. Peer review and the support of science[J]. Scientific American. 1977,237(4):34.

[4] 邱均平. 信息计量学(九):第九讲 文献信息引证规律和引文分析法. 情报理论与实践[J]. 2001, 24(3):236-40.

[5] Al Kawi MZ. History of medical records and peer review[J]. Annals of Saudi Medicine. 1997,17(3):277-8.

[6] Ajlouni KM, Al-Khalidi U. Medical records, patients outcome, and peer review in eleventh-century Arab medicine[J]. Annals of Saudi Medicine. 1997,17(3):326-7.

[7] Macri EM, Khan KM. Single-blind peer review: an appropriate compromise between two ideals?[J]. Learned Publishing. 2011,24(3):164–5.

[8] Blank RM. The Effects of Double-Blind versus Single-Blind Reviewing: Experimental Evidence from The American Economic Review[J]. American Economic Review. 1991,81(5):1041-67.

[9] Walsh E, Rooney M, Appleby L, Wilkinson G. Open peer review: a randomised controlled trial[J]. British Journal of Psychiatry. 2000,176(176):47-51.

[10] Van RS, Godlee F, Evans S, Black N, Smith R. Effect of open peer review on quality of reviews and on reviewers' recommendations: a randomised trial[J]. Bmj Clinical Research. 1999, 318(7175):23-7.

[11] Mcnutt RA, Evans AT, Fletcher RH, Fletcher SW. The effects of blinding on the quality of peer review[J]. A randomized trial. Jama. 1990, 263(10):1371.

[12] Laband DN, Piette MJ. Does the "Blindness" of Peer Review Influence Manuscript Selection Efficiency?[J]. Southern Economic Journal. 1994, 60(4):896.

[13] Smith R. Peer review: reform or revolution?[J]. BMJ: British Medical Journal. 1997,315(7111):759.

[14] Rooyenc SV, Godlee F. Effect of blinding and unmasking on the quality of peer review. Journal of General Internal Medicine. 1999,14(10):622-4.

[15] Relman AS. Peer review in scientific journals--what good is it? Western Journal of Medicine. 1990,153(5):520-2.

[16] Okike K, Hug KT, Kocher MS, Leopold SS. Singleblind vs Double-blind Peer Review in the Setting of Author Prestige. Jama. 2016,316(12):1315.

[17] Budden AE, Tregenza T, Aarssen LW, Koricheva J, Leimu R, Lortie CJ. Double-blind review favours increased representation of female authors. Trends in Ecology & Evolution. 2008,23(1):4–6.

[18] Garvalov BK. Who stands to win from double-blind peer review? 2015,2.

[19] Moylan EC, Harold S, O’Neill C, Kowalczuk MK. Open, single-blind, double-blind: which peer review process do you prefer? BMC Pharmacology and Toxicology. 2014,15(1):55.

[20] Fletcher RH, Fletcher SW, Fox R, Horrobin D, Lock S, Pepper K, et al. Anonymity of reviewers. Cardiovascular Research. 1994,28(8):1134-9, discussion 40-5.

[21] Garfield E, editor Citation analysis as a tool in journal evaluation1972: American Association for the Advancement of Science.

[22] Garfield E. Citation indexes for science. A new dimension in documentation through association of ideas. 1955. Science. 1955,122(5):1127-8.

[23] Hirsch JE. An index to quantify an individual's scientific research output. Proceedings of the National Academy of Sciences of the United States of America. 2005,102(46):16569-72.

[24] E.Garfield, 丁鸿富. 科学和引证分析. 世界科学. 1984,(12):9+53-6.

[25] Macroberts MH, Macroberts BR. Problems of citation analysis. Scientometrics. 1996,36(3):435-44.

[26] Glänzel W. On the h-index - A mathematical approach to a new measure of publication activity and citation

impact. Scientometrics. 2006,67(2):315-21.

[27] Van Raan AFJ. Comparison of the Hirsch-index with standard bibliometric indicators and with peer judgment for 147 chemistry research groups. Scientometrics. 2013,67(3):491-502. doi: 10.1556/Scient.67.2006.3.10.

[28] 唐野琛. 基于信息价值的h型指数比较研究. 高校图书馆工作. 2011,31(6):13-5.

[29] 金碧辉, Ronald. R指数、AR指数:h指数功能扩展的补充指标. 科学观察. 2007,(3):1-8.

[30] Bornmann L, Mutz R, diger, Daniel HD. Are there better indices for evaluation purposes than the h index? A comparison of nine different variants of the h index using data from biomedicine: John Wiley & Sons, Inc., 2008. 830–7 p.

[31] 安静, 夏旭, 李海燕, 王瑜, 赵镇. 类h指数:K指数的修正机理及实证分析. 科技管理研究. 2009,(6):382-4.

[32] Egghe L. Theory and Practice of the g-Index. Scientometrics. 2006,69(1):131-52.

[33] Wu Q. The w-index: A significant improvement of the h-index. Arxiv Cornell University Library. 2008.

[34] Eck NJV, Waltman L. Generalizing the h - and g-indices. Journal of Informetrics. 2008,2(4):263-71.

[35] Imperial J, Rodríguez-Navarro A, editors. Usefulness of Hirschs h-index to evaluate scientific research in Spain. Scientometrics, 2007.

[36] Csajbók E, Berhidi A, Vasas L, Schubert A. Hirsch-index for countries based on Essential Science Indicators data. Scientometrics. 2007,73(1):91-117.

[37] Egghe L, Rao IKR. Study of different h-indices for groups of authors. Journal of the Association for Information Science and Technology. 2008,59(8):1276–81.

[38] Banks MG. Banks, M.: An extension of the Hirsch index: Indexing scientific topics and compounds. Scientometrics 69(1). Scientometrics. 2006,69(1):161-8.

[39] Liu Y, Rousseau R. Hirsch-type indices and library management: The case of Tongji University Library. 2007.

[40] Grothkopf U, Stevensrayburn S. Introducing the H-Index in Telescope Statistics. Library & Information Services in Astronomy. 2006,377:86.

[41] Korn A, Schubert A, Telcs A. Lobby index in networks. Physica A Statistical Mechanics & Its Applications. 2009,388(11):2221-6.

[42] Alonso S, Cabrerizo FJ, Herrera-Viedma E, Herrera F. hg -index: a new index to characterize the scientific output of researchers based on the h - and g -indices. Scientometrics. 2010,82(2):391-400.

[43] Wu Q. The w-index: A measure to assess scientific impact by focusing on widely cited papers. Journal of the Association for Information Science and Technology. 2010,61(3):609–14.

[44] Kosmulski M. A new Hirsch-type index saves time and works equally well as the original h-index. ISSI newsletter. 2006,2(3):4-6.

[45] Sidiropoulos A, Katsaros D, Manolopoulos Y. Generalized Hirsch h-index for disclosing latent facts in citation networks. Scientometrics. 2007,72(2):253-80.

[46] Batista PD, Campiteli MG, Kinouchi O. Is it possible to compare researchers with different scientific interests? Scientometrics. 2006,68(1):179-89.

[47] Schreiber M. EDITORIAL: To share the fame in a fair way, hm modifies h for multi-authored manuscripts. New Journal of Physics. 2008,10(4):1131-7.

[48] Anderson TR, Hankin RKS, Killworth PD. Beyond the Durfee square: Enhancing the h-index to score total publication output. Scientometrics. 2008,76(3):577-88.

[49] Price DJ. NETWORKS OF SCIENTIFIC PAPERS. Science. 1965,149(3683):510-5.

[50] Pinski G, Narin F. Citation influence for journal aggregates of scientific publications: Theory, with application to the literature of physics ☆. Information Processing & Management. 1976,12(5):297-312.

[51] Page L. The PageRank citation ranking : Bringing order to the web. Stanford Digital Libraries Working Paper. 1998,9(1):1-14.

[52] Chen P, Xie H, Maslov S, Redner S. Finding scientific gems with Google’s PageRank algorithm. Journal of Informetrics, 1(1), 8-15. Journal of Informetrics. 2008,1(1):8-15.

[53] Ma N, Guan J, Zhao Y. Bringing PageRank to the citation analysis. Information Processing & Management. 2008,44(2):800-10.

[54] Gleich DF. PageRank beyond the Web. Computer Science. 2014,57(3).

[55] Ermann L, Frahm KM, Shepelyansky DL. Google matrix analysis of directed networks. Review of Modern Physics. 2016,87(4).

[56] Walker D, Xie H, Yan KK, Maslov S. Ranking Scientific Publications Using a Simple Model of Network Traffic. Journal of Statistical Mechanics Theory & Experiment. 2007,6(6).

[57] Mei Q, Guo J, Radev D, editors. DivRank: the interplay of prestige and diversity in information networks. ACM SIGKDD International Conference on Knowledge Discovery and Data Mining, 2010.

[58] Mariani MS, Medo M, Zhang YC. Identification of milestone papers through time-balanced network centrality. Journal of Informetrics. 2016,10(4):1207-23.

[59] Su C, Pan YT, Zhen YN, Ma Z, Yuan JP, Guo H, et al. PrestigeRank: A new evaluation method for papers and journals. Journal of Informetrics. 2011,5(1):1-13.

[60] Yao L, Wei T, Zeng A, Fan Y, Di Z. Ranking scientific publications: The effect of nonlinearity. Scientific Reports. 2014,4:6663.

[61] Zhou J, Zeng A, Fan Y, Di Z. Ranking scientific publications with similarity-preferential mechanism. Scientometrics. 2016,106(2):1-12.

[62] Zhou YB, Lü L, Li M. Quantifying the influence of scientists and their publications: Distinguish prestige from popularity. New Journal of Physics. 2011,14(3):33033-49(17).

[63] Lü L, Chen D, Ren XL, Zhang QM, Zhang YC, Zhou T. Vital nodes identification in complex networks. Physics Reports. 2016,650.

[64] Bollen J, Rodriquez MA, Van de Sompel H. Journal status. Scientometrics. 2006,69(3):669-87.

[65] Bergstrom C. Measuring the value and prestige of scholarly journals. College & Research Libraries News. 2007,68(5):314-6.

[66] Rousseau R. On the relation between the WoS impact factor, the Eigenfactor, the SCImago journal rank, the article influence score and the journal h-index. 2009.

[67] Bergstrom CT, West JD. Assessing citations with the Eigenfactor metrics. Neurology. 2008,71(23):1850-1.

[68] 任胜利. 特征因子(E i g e n f a c t o r):基于引证网络分析期刊和论文的重要性. 中国科技期刊研究. 2009,20(3):415-8.

[69] Davis PM. Eigenfactor: Does the principle of repeated improvement result in better estimates than raw citation counts? Journal of the Association for Information Science and Technology. 2008,59(13):2186–8.

[70] 刘艳华, 华薇娜. 期刊评价新指标——特征因子. 情报杂志. 2010,29(7):122-6.

[71] Butler D. Free journal-ranking tool enters citation market. Nature. 2008,451(7174):6.

[72] Berset Y, Medo M. The effect of the initial network configuration on preferential attachment. European Physical Journal B. 2013,86(6):1-7.

[73] Radicchi F, Fortunato S, Castellano C. Universality of citation distributions: toward an objective measure of scientific impact. Proc Natl Acad Sci U S A. 2008,105(45):17268-72.

[74] Newman MEJ. The first-mover advantage in scientific publication. Epl. 2008,86(6):68001-6.

[75] Bianconi G, Barabási AL. Bose-Einstein Condensation in Complex Networks. Physrevlett. 2001,86(24):5632-5.

[76] Wang D, Barabási AL. Quantifying long-term scientific impact. Science. 2013,342(6154):127-32.

[77] Hua-Wei S, Albert-László B. Collective credit allocation in science. Proceedings of the National Academy of Sciences of the United States of America. 2014,111(34):12325.

[78] Bar-Ilan J. Informetrics at the beginning of the 21st century—A review. Journal of Informetrics. 2008,2(1):1-52.

所有评论仅代表网友意见