在刚刚结束的第八届ImageNet大规模视觉识别挑战赛(ILSVRC 2017)上,南京信息工程大学和伦敦帝国理工学院的BDAT,新加坡国立大学和奇虎360联队(NUS-Qihoo_DPNs),伦敦帝国理工学院和悉尼大学联队(IC&USYD)分别拿下“物体检测、物体定位、视频物体检测”三项比赛的冠军。Momenta公司与牛津大学联队(WMW)在物体分类单项指标上取得突破,Top5错误率低至2.25%。

视觉识别评测

ImageNet挑战赛是一项什么样的比赛?近年来,计算机视觉技术飞速发展,各项任务都取得长足进步。这一过程中,视觉识别评测扮演了非常重要的角色。研究人员通过构建标准化的数据集和评测方法,建立统一衡量标准,加速算法创新。计算机视觉领域常见的评测数据集包括:物体识别检测及分割任务的PASCAL VOC、ILSVRC (ImageNet Large Scale Visual Recognition Challenge)、COCO (Common Objects in Context), 人脸识别任务的LFW (Labeled Faces in the Wild), 自动驾驶任务的KITTI等;视频评测数据集TRECVID、ActivityNet等。

在众多的视觉识别评测数据集中,规模最庞大、影响最深远的当属ILSVRC。ILSVRC发端于ImageNet数据集[1],该数据集由李飞飞、李凯教授等人自2009年开始在普林斯顿大学构建,采用众包方式在亚马逊土耳其机器人(Mechanical Turk)上进行数据标注。目前该数据集共收集标注图片14,197,122张,图片类别21841种。

从2010年起,每年组织一次ImageNet挑战赛,即ILSVRC。比赛数据采用包含128万图片、1000个类别的ImageNet子集1。ILSVRC逐渐吸引了学术界和工业界大量研究人员参与,带动整个计算机视觉领域不断取得突破。甚至如戴夫·格尔什戈林(Dave Gershgorn)所言[2],如若我们将当下正在经历的人工智能技术大爆发归结于某个单一事件的话,无疑应当是ILSVRC 2012比赛结果宣布的那一刻。在ILSVRC 2012中,多伦多大学的亚力克斯·克里泽夫斯基(Alex Krizhevsky)等人[3]提出了一种深度卷积神经网络结构AlexNet,夺得了挑战赛冠军,成绩比当时的第二名高出41%。而后具有广泛影响力的VGGNet[4]、Inception[5]、ResNet[6]等工作均源自于历届ImageNet挑战赛。特别值得一提的是,在ILSVRC 2016中,来自中国学术界和工业界的香港中文大学、公安部第三研究所、南京信息工程大学、海康威视、商汤科技等团队包揽了所有项目的冠军。

ILSVRC 2017比赛结果及分析

ILSVRC 2017作为第八届也是最后一届ImageNet挑战赛,不久前刚刚结束。最终标准数据集上位列前茅的参赛队成绩如表1~4所示。

表1 物体分类

队名 错误率(%) | |

WMW | 0.0225 |

Trimps-Soushen | 0.0248 |

NUS-Qihoo_DPNs | 0.0274 |

BDAT | 0.0296 |

表2 物体定位

队名 错误率(%) | |

NUS-Qihoo_DPNs | 0.0623 |

Trimps-Soushen | 0.0650 |

BDAT | 0.0814 |

SIIT_KAIST-SKT | 0.1290 |

表3 物体检测

队名 获胜类别/mAP% | |

BDAT | 85 / 0.732 |

NUS-Qihoo_DPNs | 9 / 0.657 |

VIST | 10 / 0.593 |

KAISTNIA_ETRI | 1 / 0.610 |

表 4 视频物体检测

队名 获胜类別/mAP%/tracking | |

IC&USYD | 15 / 0.817 / 0.641 |

NUS- QihooUIUC_DPNs (VID) | 3 / 0.758 / 0.545 |

THU-CAS | 0 / 0.730 / 0.512 |

从比赛结果可以看出,物体分类和定位任务的准确率,在当前数据集上已经趋于极限。在ILSVRC 2016 workshop中,公安部第三研究所“搜神”团队(Trimps-Soushen)曾对验证集上错误率为2.9%的模型进行了分析[7]。他们将错误样本分为标注错误、多目标、主目标不显著、类别易混淆、仅包含部分目标、精细分类、模型失误等七大类。很显然,除最后两种类型的错误之外,其他类型的错误已很难依靠模型改善而获得提升。物体定位任务同样如此,排名前列的几个参赛队,其模型正确定位率(正确分类的数量/正确分类且正确定位的数量)已经达到或超越96%,考虑到数据集本身的标注错误以及很多边界难以界定的场景类别(如码头、悬崖、海角、喷泉等),定位性能已经没有太大的提升空间。

对于物体检测和视频物体检测任务,目前最佳性能分别为mAP 0.732、mAP 0.817,尚有改进空间。特别是视频物体检测仅包含30类,我们可以期待算法进步将带来性能的提升。

目前仅有少数参赛队公开了实现细节。我们根据比赛提交信息及ILSVRC 2017 workshop对算法做简略分析后,注意到今年的比赛算法有以下几个特点。

追求模型精度和模型效率的均衡

NUS-Qihoo_DPNs提出一种双路径网络[8],有效结合了ResNet[6]和DenseNet[9],与当前主流模型相比,在性能提升的情况下,模型规模、计算代价、内存占用均大幅降低。IC&USYD参考了微软亚洲研究院的深度特征流模型,采用稀疏关键帧的深度特征传播机制实现识别速度的提升。

模型设计上融入注意力机制

注意力机制作为近年来深度学习研究领域的热点,被广泛应用于计算机视觉和自然语言处理等问题中,在今年的挑战赛中亦被多个团队借鉴。BDAT在分类任务中引入了香港中文大学提出的自适应注意力模型。WMW提出的“挤压与激励”(Squeeze-and-Excitation)算法,也可看到注意力机制的某种形式,它通过学习获得卷积特征通道的重要程度,并据此提升有用特征并抑制无效特征。

残差网络及其变种占据绝对主力

残差网络[6]以其原理简单、易于实现、性能出众、方便拓展等优势,成为许多参赛团队设计网络模型的基础,而相关工作已经在CVPR 2016和CVPR 2017连续两年获最佳论文,也充分显示了学术界和工业界的认可。

视觉识别评测趋势及展望

ImageNet挑战赛完成了历史使命,完美谢幕。但是这并不代表计算机视觉问题得到了完美解决。目前的识别算法并不理解它看到的物体。同时在视频理解领域,算法性能仍不尽人意,有待研究人员继续深入探索。展望未来,以下方向值得关注。

规模更大的图像数据集 ImageNet能够取得巨大成功,其庞大的数据规模是一个重要因素。ILSVRC仅利用了一个1000类子集,有些研究工作将数据拓展到更大的范围,如ResNext[10]模型使用了5000类子集作为训练集。

在更大规模数据集方面,谷歌公司公开的Open Images[11]包含约900万张图片,超过6000个类别,并且在其2.0版本中增加了多达600类、120万个物体标注框。

JFT是谷歌公司的一个内部数据集,目前已经包含3亿张图片、3.75亿个标注,类别18291种。孙晨(Chen Sun,音译)等[12]研究人员的实验表明,在数据规模呈数量级增加的JFT上进行训练,可以使多个视觉识别任务性能获得线性提升。

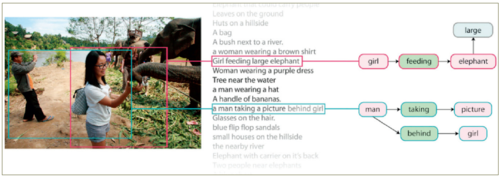

从图像识别到图像理解 ILSVRC的错误率低至2%左右,这仅仅指图像物体识别的问题,现有算法并不知道物体的特性——物体的来源、用途、制造者以及如何与周围物体交互等等,简而言之,图像理解的目标尚未实现。与图像理解相关的研究任务包括,属性预测、关系检测、图像描述、视觉问答等。

Visual Genome[13]是针对图像理解 (认知) 任务而构建的数据集,该数据集对10.8万张图像数据进行了物体、属性、关系对以及图片子区域的语言描述等密集标注,并按照WordNet语义进行规范化,平均每张图像标注多达35个物体、26个属性、21个关系对。

图1 VisualGenome标注示意图

图像描述任务是一个新型的交叉研究方向,它既包含了计算机视觉的内容,也包含了自然语言处理领域的方法,因此非常具有挑战性。目前使用最广泛的图像描述数据集是COCO captioning dataset[14]。该数据集包含82,783张训练集图片,40,504张验证集图片,每张图片含有5条人工标注的描述语句。在官方评测榜上,当前性能最好的结果来自IBM的沃森(Watson)。

从图像到视频 与静态图像相比,视频理解研究仍有较大的提升空间。近年来,研究人员构建了多个大规模的视频数据集,以期推动该领域的研究。

谷歌公开的YouTube-8M数据集[15]包含700多万个YouTube网站的视频链接,标注种类达4716类,平均每个视频包含3.4个标签,同时提供基于Inception-V3模型的帧级特征及视频级特征下载。在2017年YouTube-8M视频理解挑战赛中,来自法国国家信息与自动化研究院(INRIA)的WILLOW斩获冠军,国内许多研究机构也有出色表现,来自清华大学、百度公司、复旦大学的团队均榜上有名。

另一项视频理解挑战赛ActivityNet 2017是基于Activity200[16](200类动作、10,024个视频片段)和Kinetics[17](400类动作、3,000,000个视频片段)数据集,包含未修剪视频分类(Untrimmed Video Classification) 、修剪动作识别(Trimmed Action Recognition)、时序动作建议(Temporal Action Proposals)、时序动作定位(Temporal Action Localization)和视频密集事件描述(Dense-Captioning Events in Video)等五项任务。来自中国的研究团队展现出强大的实力,五项冠军依次被南京信息工程大学、清华大学、上海交通大学和哥伦比亚大学联队、上海交通大学和哥伦比亚大学联队、微软亚洲研究院等团队获得。

FCVID[18] (Fudan-Columbia Video Dataset) 是视频领域的又一个大规模数据集,该数据集由复旦大学和哥伦比亚大学共同构建,共收集网络视频片段91,223个,包含类别239种。基于该数据集的视频分类挑战赛目前正在火热进行中,比赛详情将在今年10月份的ACM Multimedia workshop上公布。

视频描述任务是对视频片段进行自然语言描述。MSVD[19]数据集包含1,970个YouTube视频片段,内容覆盖了运动、烹饪、演奏音乐等各类日常活动。MSR-VTT[20]是2016年由微软亚洲研究院发布的一个大规模视频描述数据集,其包含20个大类共计10,000个视频片段,每个视频片段人工标注了20条描述语句。MSR-VTT在2016和2017年分别举办了两届挑战赛,冠军都被卡内基梅隆大学和中国人民大学联队摘得。

通过构建大规模视觉识别评测数据集,结合算法创新,计算机视觉的各项任务均取得了巨大进步。来自中国的研究人员已经在这些领域中大放异彩,成为推动领域发展的中流砥柱。同样,我们也认识到目前研究中存在的缺陷和不足。在最后一届ImageNet挑战赛 workshop上,李飞飞教授非常贴切地引用英国前首相温斯顿·丘吉尔的名言作为其演讲的结束语:这并非结束,甚至结束都还没开始,但也许,我们已经起步。 ■

脚注:1在ILSVRC 2015中包括基于Place2数据集的比赛任务,在ILSVRC 2016中包括基于Place2和ADE20K数据集的比赛任务。

参考文献:

[1] Deng J, Dong W, Socher R, et al. Imagenet: A large-scale hierarchical image database[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2009: 248-255.

[2] The Data that Transformed AI Research[OL].https://qz.com/1034972/the-data-that-changed-the-direction-of-ai-research-and-possibly-the-world/.

[3] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Curran Associates Inc., 2012: 1097-1105.

[4] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[OL]. arXiv preprint arXiv:1409.1556, 2014.

[5] Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]//Proceedings of the IEEE conference on Computer Vision and Pattern Recognition. 2015: 1-9.

[6] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2016: 770-778.

[7] Shao J, Zhang X, Ding Z, et al. Good Practice for Deep Feature Fusion[OL].http://image-net.org/challenges/talks/2016/Trimps-Soushen@ILSVRC2016.pdf.

[8] Chen Y, Li J, Xiao H, et al. Dual Path Networks[OL]. arXiv preprint arXiv:1707.01629, 2017.

[9] Huang G, Liu Z, Weinberger K Q, et al. Densely connected convolutional networks[OL]. arXiv preprint arXiv:1608.06993, 2016.

[10] Xie S, Girshick R, Dollár P, et al. Aggregated residual transformations for deep neural networks[OL]. arXiv preprint arXiv:1611.05431, 2016.

[11] https://github.com/openimages/dataset

[12] Sun C, Shrivastava A, Singh S, et al. Revisiting Unreasonable Effectiveness of Data in Deep Learning Era[OL]. arXiv preprint arXiv:1707.02968, 2017.

[13] Krishna R, Zhu Y, Groth O, et al. Visual genome: Connecting language and vision using crowdsourced dense image annotations[J]. International Journal of Computer Vision, 2017, 123(1): 32-73.

[14] Chen X, Fang H, Lin T Y, et al. Microsoft COCO captions: Data collection and evaluation server[OL]. arXiv preprint arXiv:1504.00325, 2015.

[15] Abu-El-Haija S, Kothari N, Lee J, et al. YouTube-8M: A large-scale video classification benchmark[OL]. arXiv preprint arXiv:1609.08675, 2016.

[16] Caba Heilbron F, Escorcia V, Ghanem B, et al. Activitynet: A large-scale video benchmark for human activity understanding[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2015: 961-970.

[17] Kay W, Carreira J, Simonyan K, et al. The Kinetics Human Action Video Dataset[OL]. arXiv preprint arXiv:1705.06950, 2017.

[18] Jiang Y G, Wu Z, Wang J, et al. Exploiting feature and class relationships in video categorization with regularized deep neural networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017.

[19] Chen D L, Dolan W B. Collecting highly parallel data for paraphrase evaluation[C]//Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies-Volume 1. Association for Computational Linguistics, 2011: 190-200.

[20] Xu J, Mei T, Yao T, et al. Msr-vtt: A large video description dataset for bridging video and language[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2016: 5288-5296.

所有评论仅代表网友意见